Стратегии охлаждения для серверных и небольших помещений | Журнал сетевых решений/LAN

В архитектуре ЦОД и больших компьютерных залов всегда предусматривается система охлаждения. При этом многие ИТ-устройства по-прежнему располагаются за пределами машинных залов в локальных серверных, филиалах и других местах, при проектировании которых никаких требований к охлаждению оборудования не предъявлялось. Плотность размещения ИТ-оборудования со временем увеличивается, а в результате распределенное ИТ-оборудование (маршрутизаторы VoIP, коммутаторы и серверы) преждевременно выходит из строя из-за перегрева.

Как правило, эти вопросы попросту игнорируются: организации начинают предпринимать необходимые меры только при возникновении проблем. Однако все больше и больше пользователей находят такой подход неудовлетворительным и требуют более активных действий по обеспечению должного уровня готовности распределенного ИТ-оборудования. Ниже излагаются основные принципы охлаждения небольших распределенных ИТ-сред и даются рекомендации по выработке эффективных спецификаций и проектированию вспомогательных систем охлаждения.

ПРИЕМЛЕМАЯ РАБОЧАЯ ТЕМПЕРАТУРА В СЕРВЕРНЫХ

Чтобы правильно подобрать решение для охлаждения серверной, сначала необходимо определить температуру, при которой будет функционировать оборудование в этом помещении. Поставщики обычно указывают максимальную температуру окружающей среды, при которой оно способно работать: для активного ИТ-оборудования средний показатель составляет 40°C (речь идет о температуре, при которой поставщик может обеспечить должную производительность и устойчивость работы своих устройств в течение гарантийного периода).

При этом необходимо помнить, что функционирование в таких условиях не обеспечивает такого же уровня готовности и долговечности, как при более низких температурах. Именно поэтому некоторые поставщики, помимо максимальной, указывают также рекомендованную рабочую температуру. Обычно она составляет от 21 до 24°C.

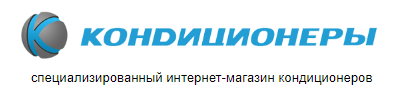

Рекомендованную и разрешенную для ИТ-оборудования рабочую температуру публикует также технический комитет TC 9.9 Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigeration, and Air Conditioning Engineers, ASHRAE). Цель заключается в том, чтобы предоставить ориентир для обеспечения необходимой устойчивости и производительности аппаратных средств. Соответствующие показатели представлены в табл. 1.

.png) |

| Таблица 1. Ограничения рабочей температуры ASHRAE TC 9.9 |

Температуру следует поддерживать не выше 25°C. Если же это невозможно, в серверных с менее критичным оборудованием верхний предел составляет 32°C. В случае превышения этого показателя есть риск выхода оборудования из строя. 32°C — это тот максимум, который Международная организация по стандартизации (International Organization for Standardization, ISO) считает допустимым при небольшой нагрузке.

Особое внимание следует уделить серверным с установленными в них источниками бесперебойного питания (ИБП). Повышение температуры гораздо сильнее влияет на долговечность батарей, чем на другие типы ИТ-оборудования. При 40°C батарея типового ИБП проработает всего 1,5 года, тогда как в нормальных рабочих условиях — 3–5 лет. Поэтому обязательным требованием должна стать температура ниже 25°C. Альтернативным вариантом может быть размещение централизованных ИБП в хорошо охлаждаемом месте за пределами серверной.

ОСНОВНЫЕ ПРИНЦИПЫ ОТВОДА ТЕПЛА

Для лучшего понимания сути вопроса полезнее было бы сформулировать его по-другому — с точки зрения отвода тепла, а не подачи холодного воздуха. Если тепло не отводить, оно будет накапливаться во всех замкнутых пространствах, где находится оборудование, а значит, температура станет повышаться. Каждый киловатт потребляемой ИТ-оборудованием электроэнергии создает киловатт тепла, которое необходимо отвести.

Тепло можно сравнить с предметом, который катится вниз. Оно передается от объекта или среды с более высокой температурой к объекту или среде, у которых температура ниже. Чтобы отвести тепло, его нужно направить в более холодное место. Во многих реальных ситуациях такая возможность отсутствует.

Тепло может покинуть небольшое замкнутое пространство, каковым являются офис или серверная, пятью различными способами:

- Естественная теплопроводность. Тепло уходит через стены во внешнюю среду.

- Пассивная вентиляция. Тепло уходит в более холодную среду через вентиляционное отверстие или решетку без применения вентилятора.

- Принудительная вентиляция. Тепло отводится с помощью вентилятора в более холодную среду через вентиляционное отверстие или решетку.

- Климат-контроль. Тепло удаляется с помощью охлаждающих систем здания.

- Выделенная система охлаждения. Тепло отводится с помощью специального кондиционера.

Пять перечисленных методов имеют разные эффективность, ограничения и стоимость. Пользователи должны понимать, какой метод используется или предлагается в конкретной ситуации, какой больше подходит с учетом существующих ограничений и предпочтений и как должны определяться требования к проекту.

На рис. 1 представлена общая схема для стратегии охлаждения в зависимости от текущей и целевой температуры в зале при обычных условиях. На ней показаны диапазоны производительности для различных методов. Не надо пытаться перевести эти ограничения в абсолютные цифры, поскольку стратегии перекрываются, а окончательное решение должно учитывать все факторы, от которых зависит степень охлаждения. Системы климат-контроля здесь не представлены, поскольку они могут быть очень разными, а их функционирование — непредсказуемым. Ниже мы рассмотрим этот вопрос более подробно.

.png) |

| Рис. 1. Сопоставление методов охлаждения в зависимости от энергопотребления и целевой температуры в зале |

ЕСТЕСТВЕННАЯ ТЕПЛОПРОВОДНОСТЬ: ТЕПЛО УХОДИТ ЧЕРЕЗ СТЕНЫ

В закрытых подсобных помещениях, которые встречаются довольно часто, единственным способом отвода тепла является кондуктивный теплообмен через стены. Чтобы этот метод работал, воздух внутри помещения должен быть более теплым, чем снаружи. Причем температура в нем растет тем сильнее, чем выше уровень энергопотребления работающего ИТ-оборудования.

.png) |

| Рис. 2. Зависимость температуры в серверной от уровня энергопотребления ИТ-оборудования. Эффективность естественной теплопроводности |

Пример соотношения между средней температурой в серверной (в предположении ее равномерного распределения) и энергопотреблением оборудования приведен на рис. 2. Данное соотношение предполагает наличие закрытого помещения размером 3 × 3 × 3 м с утечкой воздуха со скоростью 23,6 л в секунду, стенами из гипсокартона и комфортным охлаждением снаружи до уровня 20°C (см. подробнее врезку «Предполагаемые условия для типовой серверной»).

Предполагаемые условия для типовой серверной

Для описания типовой серверной обычно используется экстенсивная модель, учитывающая теплопроводность стен, конвекцию и излучение. Под конвекцией понимаются естественный теплообмен со стенами комнаты и заданный воздушный поток (в результате утечки воздуха). Предположения об условиях в «типовой» серверной приведены ниже.

.png) |

| Параметры типовой серверной |

Как видно из рисунка, такая типовая серверная поддерживает энергопотребление до 400 Вт, если температура в ней не должна превышать 25°C, и 1000 Вт, если приемлемым уровнем считается значение 32°C.

Впрочем, серверные отличаются своими размерами и использованными стройматериалами, а на соотношение между температурой и энергопотреблением влияют и другие факторы, которые ограничивают использование этого метода. Основные факторы и характер их влияния перечислены в табл. 2.

.png) |

| Таблица 2. Факторы, оказывающие влияние на температуру в серверной, и ожидаемый результат их воздействия |

Наиболее очевидный фактор — размеры помещения. Чем больше комната, тем лучше рассеивается тепло благодаря большей площади стен, потолка и пола. И чем она меньше, тем ниже эффективность охлаждения за счет естественной теплопроводности. Разница в эффективности представлена на рис. 3.

.png) |

| Рис. 3. Влияние размеров помещения на эффективность охлаждения за счет естественной теплопроводности |

Материалы, используемые при строительстве стен, потолка и пола, тоже оказывают влияние на соотношение между температурой и рабочей нагрузкой, поскольку способность пропускать тепло у разных материалов разная. Если мы заменим стены из гипсокартона и панельный подвесной потолок, приведенные в примере выше, на 10-сантиметровые бетонные стены и 10-сантиметровые железобетонные перекрытия, эффективность охлаждения заметно повысится. Это наглядно можно увидеть на рис. 4.

.png) |

| Рис. 4. Влияние строительных материалов на эффективность охлаждения за счет естественной теплопроводности |

Зачастую эффективность охлаждения за счет естественной теплопроводности снижается из-за повышения температуры внутри здания после отключения систем кондиционирования на выходные. Когда такое происходит, температура в серверной с ИТ-оборудованием синхронно увеличивается. В нашем примере при увеличении в выходные дни температуры внутри здания с 20 до 29°C (то есть на 9°C) можно ожидать соответствующего увеличения на 9°C и внутри серверной. Это означает, что в критичной серверной, где температура не должна превышать 25°C, придется отключить всю нагрузку, а в некритичной, где можно допустить 32°C, уровень энергопотребления не должен быть выше 250 Вт.

Еще одно ограничение такого метода охлаждения связано с тем, что, если стены помещения одновременно являются внешними стенами здания, температура внутри будет зависеть от температуры внешней стены, на которую влияют как состояние окружающей среды, так и нагрев под воздействием солнца. Поэтому помещение, примыкающее к наружным стенам, в солнечные дни может перегреваться. В нашем примере в комнате размером 3 × 3 × 3 м при температуре 38°C на улице и солнечной теплоотдаче 1000 Вт/м2 можно ожидать повышения температуры внутри помещения на 4–7°C.

Эффективность охлаждения за счет естественной теплопроводности в закрытых помещениях варьируется в зависимости от их размеров, конструкционных материалов и внешних условий. В общем случае охлаждения исключительно за счет теплопроводности в критичных залах оказывается достаточно, если общее энергопотребление внутри помещения не превышает 400 Вт. При этом следует учитывать влияние и других факторов, перечисленных выше. В некритичных помещениях такой тип охлаждения можно использовать, если энергопотребление оборудования не превышает 1000 Вт.

Итак, этот метод пригоден только при использовании маломощных ИТ-устройств, например стековых сетевых коммутаторов. Как видно из приведенных выше примеров, при увеличении энергопотребления температура быстро увеличивается. Учтите, что тепло выделяют и другие потребители энергии, в частности электрические лампочки. Поэтому освещение зала нужно организовать с использованием экономичных источников, которые автоматически отключались бы, когда в помещении никого нет.

ПАССИВНАЯ И ПРИНУДИТЕЛЬНАЯ ВЕНТИЛЯЦИЯ: ТЕПЛО ОТВОДИТСЯ В БОЛЕЕ ХОЛОДНУЮ СРЕДУ ЧЕРЕЗ ВЕНТИЛЯЦИОННЫЕ ОТВЕРСТИЯ И РЕШЕТКИ

Залы можно охлаждать с помощью воздуха, поступающего из остальной части здания. При этом применяется как пассивная вентиляция через специальные отверстия и воздухозаборники, так и активная — с помощью вентиляторов. Основное условие заключается в том, чтобы температура в зале не превышала значительно температуру в здании.

Примеры систем вентиляции представлены на рис. 5. Как показано на рис. 6, температура в вентилируемом помещении меняется в соответствии с уровнем энергопотребления ИТ-оборудования.

.jpg) |

| Рис. 5. Примеры двух типов вентиляции помещений: а — пассивная вентиляция; б — принудительная вентиляция |

В графическом виде эта ситуация представлена на рис. 5. Кривая пассивной вентиляции характеризует работу оборудования, изображенного на рис. 5, а. В случае принудительной вентиляции (рис. 5, б) температура повышается медленнее (по сравнению с пассивной), при этом предполагается, что поток воздуха генерируется со скоростью 226,5 л в секунду. Рост температуры снижается по мере увеличения потока воздуха. Для этого необходимо установить вентиляторы большей мощности или дополнительную вентиляционную систему.

.png) |

| Рис. 6. Зависимость температуры в помещении от энергопотребления ИТ-оборудования при пассивной и принудительной вентиляции |

Вентиляция — очень практичный метод охлаждения зала. Для критичных помещений при энергопотреблении ниже 700 Вт вполне достаточно пассивной вентиляции, а если энергопотребление составляет от 700 до 2000 Вт, справится принудительная. Поддержка еще более высоких уровней энергопотребления достигается путем увеличения мощности вентиляторов или установки дополнительных вентиляционных систем.

В некритичных помещениях для энергопотребления, не превышающего 1750 Вт, достаточно пассивной вентиляции, а в случае 1750–4500 Вт — принудительной. Правильное размещение вентиляционных отверстий и вентиляторов по отношению к ИТ-оборудованию тоже способствует эффективному охлаждению. При этом методе важное значение имеют внешние факторы, роль которых была проиллюстрирована на рис. 4 и 5.

Охлаждение серверной. Куда потратить деньги с пользой / Habr

На написание этой публикации меня подвигли 4 вещи:1. Публикация «Почему важно поддерживать температурный режим в серверной. Как обычно устроено охлаждение серверной», в которой автор попытался выполнить почетную и очень трудную миссию по разъяснению необходимости охлаждать сервера.

2. Ошибки, вычитанные в этом посте.

3. Собственный опыт.

4. Стремящееся к нулю количество содержательных статей по тематике инфраструктуры ЦОД (я подразумеваю, что серверная = маленький ЦОД) на Хабре. Хотя «Билайн» и ребята из «ЦОДы.рф» в этом плане большие молодцы.

Итак, о чем будет этот публикация.

В первую очередь это будет небольшой экскурс в теорию холодоснабжения серверных. Во вторую очередь я попытаюсь разобраться с основными заблуждениями при планировании холодоснабжения. И в третью – разбор, куда же все-таки стоит вложить денег, а от чего можно отказаться.

На сегодня в холодоснабжении ЦОД существуют две глобальные стратегии:

1. Свободное охлаждение. Это когда сервера охлаждаются напрямую внешним воздухом с минимальной его подготовкой (обычно это базовая фильтрация и подогрев в зимний период).

2. Контролируемое холодоснабжение, назовем его так. Это когда вы готовите воздух по показателям загрязнения, влажности, температуры и подаете его в сервера. Сюда же входят различные методы косвенного фрикулинга (используется внешний воздух для охлаждения теплообменника в котором находится воздух из ЦОД).

Преимущества первой стратегии очевидны. Это низкая стоимость внедрения, низкая стоимость обслуживания, смешные счета за электроэнергию. Недостатки тоже понятны. Неконтролируемая влажность и запыленность воздуха, что неминуемо приводит к выходу из строя компонентов серверов. У такого подхода есть свои приверженцы. Обычно это очень крупные технологические компании. Почему это хорошо для них и плохо для остальных? Есть 3 причины:

1. Сеть полностью резервируемых площадок. Если произойдет сбой на одной, подхватит вторая.

2. Необходимость быть на пике технологий. Сервер, работающий с плохим воздухом, выйдет из строя примерно за год. За год эти компании поменяют поменяют парк серверов на треть. Им нет смысла беречь железо, которое через год уйдет на помойку.

3. Объемы и счета за электроэнергию. Охлаждение – наиболее затратная статья в счетах за электроэнергию. Сокращение расходов на охлаждение на 1% сэкономит им несколько миллионов долларов. Что уж говорить про сокращение на 30-50%. И они готовы терпеть некоторые неудобства.

Вторая стратегия подразумевает большую надежность и продолжительный срок эксплуатации охлаждаемого оборудования. Наиболее традиционный пример — это банковская отрасль. Ну и все остальные компании, которые не меняют сервера как перчатки. Недостатки этой стратегии – цена, цена, цена. Строительства, обслуживания, электричества.

Понятно, что большинство компаний рассматривают вариант «максимально функционально и без изысков». Однако просто не всегда просто. Бывает просто и правильно, а бывает совсем наоборот (я прям боксером себя почувствовал).

Плавно перейдем к более практическим вещам. Когда говорят про охлаждение серверов, в первую очередь подразумевают контроль температуры. Это верно, но недостаточно. Три столпа правильного охлаждения – это температура, объем воздуха и его влажность. Вторым эшелоном идет управление воздушными потоками, то есть как направить холодный воздух туда, где его заберет сервер и как забрать горячий воздух с «выброса» сервера и направить его в кондиционер. И как при этом сделать, чтобы горячий и холодный воздух не перемешивался.

С температурой все просто. Есть рекомендации производителя сервера, есть рекомендации ASHRAE. Нормальной температурой для большинства серверных я считаю 22-24 градуса.

Если про температуру все помнят, то про объем воздуха не думает практически никто из строящих серверную. Давайте посмотрим на технические параметры сервера. Помимо потребления, размеров и т.п. там есть параметр, обычно измеряемый в CFM (кубические футы в минуту) – это объем прокачиваемого воздуха. То есть вашему серверу нужен воздух определенной температуры и в определенном объеме. Толстым шрифтом с капсом «в определенном объеме». Здесь мы сразу переходим к возможности использования бытовых сплит-систем в серверной. Штука вот в чем — они не справятся с необходимым объемом. Дело в том, что удельное тепловыделение человека несопоставимо мало по сравнению с сервером, а бытовые кондиционеры рассчитаны именно на создание комфортного климата для человека. Их маленькие вентиляторы (как передние конечности тираннозавра) не способны прогнать через себя объем воздуха, необходимого для охлаждения сервера. В результате мы получаем картину, когда сервер прогоняет через себя воздух, кондиционер не может его забрать и горячий воздух перемешивается с холодным. Вы, наверняка, бывали в серверной, где кондиционер выдает +16 градусов, а в помещении +28. Я бывал. Может быть, ваша серверная именно такая?

Ну и чтоб два раза не вставать:

1. Бытовые сплиты рассчитаны на работу 8/5, а серверная работает 24/7. Свой ресурс сплит выработает за год-полтора.

2. Сплиты не умеют подавать воздух нужной температуры на сервер, они умеют выбрасывать из себя воздух нужной температуры, а уж что там попадет на сервер – им все равно (вот такие они гады).

3. У них слишком близко расположены забор и выброс воздуха, а это значит, что горячий и холодный воздух неизбежно будет перемешиваться (и тут см. п.2).

4. Очень трудно заставить сплиты работать в соответствии с показаниями датчиков температуры (и тут опять см. п.2).

В общем, не используйте бытовые сплиты. Не надо. В продолжительном периоде, хороший прецизионный кондиционер выйдет дешевле сплита.

Что касается контроля влажности. В упомянутой вначале статье есть один неправильный посыл. Влажностью нужно управлять, это несомненно. Но только нужно не сушить, а увлажнять воздух. Дело в том, что серверное помещение имеет замкнутый воздухообмен (по-крайней мере должно). И количество влаги в воздухе на стадии 0 (запуск серверной) там находится в определенных пределах. В процессе охлаждения, большинство влаги конденсируется на теплообменнике кондиционера (слишком высока разница температур) и сбрасывается в дренаж. Воздух становится слишком сухим, а это статика на платах и снижение теплоемкости воздуха. Поэтому хорошей тратой денег будет покупка производительного увлажнителя и системы водоподготовки к нему.

Момент, связанный с управлением воздушными потоками. В подавляющем большинстве случаев, блоки вентиляторов в шкафах абсолютно бесполезны. Они тянут воздух снизу вверх, а сервера его тянут спереди назад. Что нужно сделать – выкинуть из сметы блоки вентиляторов и заложить заглушки на пустые юниты в шкафу. Хоть досками заколотите, но закройте все дыры, через которые воздух из задней части шкафа может попасть в переднюю. Пассивные способы управления воздухом в большинстве случаев работают лучше, чем активные. И стоят дешевле.

Мониторинг микроклимата. Очень важный момент. Без мониторинга вы никогда не узнаете, что у вас работает не так, как задумывалось. Мониторить надо и температуру и влажность. Влажность можно мониторить в самой удаленной от увлажнителя точке, поскольку этот показатель одинаков для любой точки помещения. А вот температуру нужно мониторить на передней двери шкафа. Если вы не применяете раздачу холодного воздуха из-под фальш-пола, то достаточно одного датчика на шкаф. Если раздаете воздух через фальш-пол (понятно, что мы уже используем правильные кондиционеры), тогда верной сратегией будет мониторить воздух на разных уровнях от пола (например 0,5 м и 1,5 м). Ну и не лишним будет упомянуть, что в серверной никогда, ни при каких обстоятельствах, нельзя ставить шкафы со стеклянными/глухими дверями. Воздух должен свободно проходить сквозь шкаф и сервер. Если у вас вдруг есть такие шкафы – снимите с них двери.

В качестве резюме:

1. Не используйте бытовые сплиты – они всё делают не так.

2. Управляйте влажностью.

3. И воздушными потоками.

4. Установите заглушки на неиспользуемые юниты шкафа.

5. Используйте шкафы с перфорацией передних и задних дверей. Если у вас нет таких, снимите двери вообще. Ну или дрель вам в руки.

6. Правильно размещайте датчики системы мониторинга. Температуру меряем на передней части шкафа, влажность – в любой части помещения.

7. Уберите из серверной батареи отопления. Они не только греют, но и поливают иногда.

8. Уберите окна. Окна – это теплопритоки и самый простой путь в помещение, минуя бронированную дверь в серверную и пять постов охраны.

9. Сделайте нормальную гидро- и паро- и теплоизоляцию помещения.

10. Инструменты вторичны. Есть огромное количество решений по охлаждению и мониторингу. Главное понять что для вас первично на сегодня, а инструмент найдется.

11. Примите тот факт, что сегодня ИТ – это не только «пропатчить kde под free bsd», VM и БД, но и такие далекие когда-то вещи как энергетика, холодоснабжение, физическая безопасность и архитектура.

Удачи вам ниве строительства правильной инфраструктуры.

Почему важно поддерживать температурный режим в серверной. Как обычно устроено охлаждение серверной

Пожалуй с самого начала хотелось бы разобраться что может представлять из себя обычная серверная комната. Как правило, это закрытое помещение, чаще всего небольших размеров, достаточных для размещения серверных стоек с определенным набором сетевого оборудования. В большинстве случаев серверная комната размещается либо в подвальном/полуподвальном помещении, либо в чердачном помещении. То есть о местоположении серверной комнаты руководство организации задумывается далеко не в первую очередь.Предположим, серверная комната находится в подвальном либо полуподвальном помещении. В этом случае кондиционирование помещения будет достаточно осуществлять обычным доступным на рынке кондиционером (сплит-системой). Однако стоит учитывать, что близость почвы и расположение помещения ниже уровня почвы тоже будет давать о себе знать. Не исключен фактор наличия избыточной влажности. Также не исключено наличие коммуникаций отопления, водоснабжения в серверной комнате либо в непосредственной близости, что будет также оказывать непосредственное влияние на температурный режим. Предположим, выбор места для серверной комнаты осуществлялся в самую последнюю очередь, и оказалось, что в помещении установлен радиатор отопления, либо проходят коммуникации с горячей водой. Это обстоятельство несомненно будет дополнительно нагружать систему охлаждения и добавит определенные риски выхода из строя оборудования в случае отказа системы охлаждения. Но не стоит забывать о том, что в некоторых случаях требуется установка дополнительной системы подогрева для поддержания температурного режима. Для этого необходим управляемый обогреватель. Система охлаждения и система отопления должны управляться унифицированным устройством,

которое позволяло бы считывать данные с датчиков температуры, влажности и передавать команды управления системам отопления либо системам охлаждения, согласно настройкам предельных значений. Приведем некоторые требования к климатическим условиям в серверной:

- Должна предусматриваться возможность отключения системы отопления;

- Система кондиционирования воздуха серверной должна быть автономной;

- Температура в серверном помещении находиться в пределах от +18 до +24 гр. Цельсия;

- Влажность воздуха в СП должна находится в пределах от 30% до 50%.

Рассмотрим ситуацию, если серверная комната расположена в чердачном помещении. Кроме тепла, вырабатываемого в процессе работы оборудования, способствовать повышению температуры будет расположение серверной в непосредственной близости от кровли, которая нагревается от солнечных лучей. Опять-таки высок риск перегрева оборудования и как следствие выхода из строя.

Как же обычно устроено охлаждение в серверной? Как правило, используется кондиционер (сплит-система), работающий круглогодично в режиме нон-стоп, то есть 24 часа и 7 дней в неделю. Система охлаждения должна быть достаточно надежной, чтобы бесперебойно работать в течение долго времени и поддерживать необходимый уровень температуры и влажности воздуха. Кроме того, в зимнее время года во время действия отрицательных температур оборудованию в серверной комнате также может потребоваться охлаждение. Также может потребоваться отопление. Для включения/выключения отопительной системы требуется система управления, которая сможет управлять обогревателем, основываясь на данных датчиков температуры и влажности.

Показатель влажности также является важным в работе вычислительного оборудования. При высокой влажности возможны появление конденсата в устройствах и коррозия, что крайне не рекомендуется для оборудования. Для поддержания оптимальной влажности воздуха необходимо выбирать соответствующий кондиционер либо использовать дополнительно осушитель воздуха. Некоторые современные сплит-системы позволяют понизить температуру, осуществить постоянный приток очищенного воздуха, но не позволяют поддерживать его оптимальную влажность. Стоит избегать использования подобных сплит-систем в серверных помещениях. Как правило, в помещении устанавливается один кондиционер, что с точки зрения обеспечения нормального температурного режима недостаточно: в случае внезапного выхода из строя кондиционера возможен перегрев оборудования и, как следствие, его выход из строя. Поэтому рекомендуется устанавливать как минимум два кондиционера. Мощность каждого кондиционера в отдельности была бы достаточной для создания необходимых климатических условий в серверной комнате. Также, используя современные системы мониторинга климата в серверной, возможна настройка поочередной работы кондиционеров для увеличения срока службы и возможности безотказной работы. Используя функции поочередной работы кондиционеров, возможно проведение профилактических работ с кондиционерами, что в конечном итоге увеличит ресурс кондиционеров и обезопасит оборудование от нежелательных повышений температуры и выхода из строя оборудования.

Пример резервирования кондиционеров:

Внутренняя система отвода тепла в современных серверах разработана таким образом, чтобы обеспечить охлаждение всех внутренних компонентов, выделяющих тепло в процессе работы. Однако корпус сервера негерметичен, и теплообмен происходит с окружающей средой серверного помещения, поэтому ошибочно считать, что температура воздуха внутри корпуса будет значительно ниже температуры в серверной. Необходимо также учитывать тот факт, что температура воздуха в серверной вне коммуникационного шкафа, в коммуникационном шкафу и непосредственно в корпусе сервера могут отличаться. Поэтому рекомендуется устанавливать температурные датчики не только в серверном помещении на потолке, но и в каждом коммуникационном шкафу, чтобы иметь объективную информацию о климатических условиях как в шкафах, так и вне их. В целях обеспечения правильной циркуляции воздуха в серверном помещении необходимо проектировать установку кондиционера/системы отопления с учётом потоков воздуха, образуемых этими системами. Для этого в серверных шкафах предусмотрена активная вентиляция, обеспечивающая доступ охлажденного воздуха непосредственно в серверный шкаф. Важным также является правильное расположение устройств в серверном шкафу. Это должно быть выполнено с учётом размеров и тепловыделения устройств. Правильным является применение 1U вентиляторов между оборудованием, которое активно выделяет тепло, чтобы обеспечить вентиляцию и необходимый отвод тепла.

Пример 1U вентиляторов:

Вентиляторы, установленные в нижней части шкафа для притока воздуха:

Вентиляторы, осуществляющие отвод теплого воздуха из шкафа:

На приведенном рисунке показана неправильная установка кондиционера. Рассмотрим очевидные ошибки:

- Кондиционер находится прямо над коммуникационным шкафом. В случае возникновения течи в кондиционере оборудование в коммуникационном шкафу окажется залито жидкостью, что может привести к нежелательным последствиям вплоть до короткого замыкания и физического выгорания компонентов оборудования.

- Кондиционер установлен почти вплотную к потолку. Подобная установка осложняет возможное проведение технического обслуживания и затрудняет циркуляцию воздуха.

Так почему же необходимо и важно поддерживать температурный режим в серверной?

В серверной комнате, как правило, располагается крайне важное и дорогостоящее оборудование. Выход из строя или временные простои в работе оборудования могут привести к материальным и финансовым потерям. Заглянем вовнутрь современного сервера и попробуем выяснить, какие компоненты наиболее критичны к изменению температуры.

Жёсткий диск.

Является, пожалуй, самым важным компонентом системы. Соответственно выход из строя жёсткого диска в случае отсутствия резервного может стать критичным для организации. Компоненты жёсткого диска являются чувствительными к изменению температуры: к резким повышениям, понижениям и к перегреву. Повышение температуры, как правило, приводит к расширению материала, из которого изготовлены головки, системы позиционирования головки, магнитные диски. Перегрев может привести к отказу жёсткого диска, что в последствии приводит к нежелательной потере важной и дорогостоящей информации.

Оперативная память.

Современная серверная оперативная память снабжена системой пассивного охлаждения и не нуждается в дополнительном охлаждении, тем не менее, стоит помнить, что пассивная система охлаждения эффективна только в определенном диапазоне температур. Если температура в серверной комнате будет повышаться, то никакие радиаторы на линейке памяти не спасут от перегрева оперативную память.

Процессор.

Современные процессоры обладают системами защиты от перегрева. Их датчики будут сигнализировать операционной системе о перегреве и предотвращать работу процессора на высоких температурах.

Наборы микросхем на платах.

Так называемые северные и южные мосты компьютера также являются мощными выделителями тепла. Обычно указанные контроллеры снабжены радиаторами пассивного охлаждения, но и они чувствительны к изменению температуры воздуха в серверной.

Суммируя все вышесказанное про компоненты сервера, можно с уверенностью сказать, что при определенных диапазонах температур встроенная система охлаждения сервера достаточно эффективна. В ситуации, когда температура выше рабочего диапазона, система охлаждения может не справиться с задачей отвода тепла. Также необходимо избегать резких температурных скачков, что может привести к потере свойств элементов материнской платы сервера.

В серверной комнате может быть сконцентрировано некоторое количество дорогостоящего оборудования, которое критично к повышению температуры, к резким изменениям температурного режима, в связи с чем необходимо правильно подходить к выбору системы охлаждения серверной. Необходимо позаботиться о резервном кондиционере и о системе контроля управления кондиционерами, в случае если возникнет неисправность основного кондиционера. Также необходимо помнить, что большинство современных устройств производит достаточное количество тепла и может за короткий промежуток времени значительно повысить температуру в закрытом помещении. Необходимым также является и правильный выбор сплит-системы, отвечающей требованиям серверной комнаты.

Заключение.

Хотелось бы напомнить, что современное вычислительное оборудование разрабатывается с учетом работы в определенных климатических условиях. Поэтому эксплуатация оборудования в условиях, отличных от рекомендованных заводом-изготовителем, может привести к выходу из строя оборудования и, как следствие, отсутствию гарантийного ремонта. Учитывая все изложенное выше, рекомендуем использовать надежные системы контроля климата серверной и надежные системы поддержания климата в серверной.

Использованые ресурсы:

www.rti-mints.ru/uploads/files/publications/295/tehn_treb_server.doc

chvcorp.ru

inpc.com.ua/data/cabinet.html

www.42u.com/cooling/in-rack-cooling/in-rack-cooling.htm

Принципы охлаждения серверных помещений — Дистрибьютор компетенций «Темпесто»

Когда в дата-центре растет мощность и плотность размещения оборудования, не только выгод, но и проблем с его обслуживанием становится больше. Одна из них – необходимость в эффективном охлаждении помещения.Зачем охлаждать серверные помещения

Одна серверная стойка в процессе работы генерирует 5–7 кВт тепла. В небольшой серверной комнате 7–10 стоек будут выделять более 50 кВт тепла. Много это или мало?

Производители серверного оборудования гарантируют его стабильную работу при температуре от +20 до +24 °C. При 40 °C серверы еще функционируют более-менее нормально, но дальше начнутся неприятные вещи: процессоры замедлят работу (включится механизм защиты «троттлинг»), при дальнейшем повышении температуры и вовсе остановятся. А простои в работе ЦОД – это потери для бизнеса денег, доверия, перспективных клиентов.

До отметки в 40 градусов доводить нежелательно и даже опасно. При +35–40 °C оборудование не будет соответствовать заявленному уровню производительности и сроку работы, которых от него ожидают. Американское общество инженеров по отоплению, охлаждению и кондиционированию воздуха (ASHRAE) рекомендует температуру для серверных +20–25 °C, а предельно разрешенную – +15–32 °C. Этих параметров необходимо придерживаться при проектировании зданий для размещения дата-центров и в процессе их эксплуатации.

Повышение температуры негативно влияет на работу традиционных накопителей HHD. Сама по себе температура опасности не представляет, так как до +50 °C жесткие диски работают в штатном режиме. Но в сочетании с возрастом накопителя ускоряет его старение. У твердотельных накопителей SSD при нагревании в ячейках MLC происходит деградация способности сохранения заряда в оксиде кремния. Соответственно их срок службы тоже уменьшается.

Не только процессоры с накопителями, но и источники бесперебойного питания страдают от повышения температуры окружающей среды. Если в нормальных рабочих условиях производитель заявляет от 3 до 5 лет работы, то при +35 °C он сокращается до полутора лет. Даже если вы размещаете централизованные ИБП за пределами серверных помещений, охлаждать их все равно нужно. При повышении температуры на каждые 10 °C сверх рекомендованных +25 °C срок эксплуатации сокращается на 10 %, так как ускоряются процессы сульфатации свинцовых пластин.

Как характеристики помещения определяют температуру

Говоря о температуре в дата-центре, мы имеем в виду не только конкретное оборудование (оно может быть разной мощности и плотности размещения), но и конкретное помещение с его особенностями.

Если серверная обслуживает небольшую компанию и находится в цокольном или подвальном помещении, с охлаждением справится бытовая сплит-система.

Для охлаждения полноценного дата-центра учитывают близость почвы, особенности прокладки инженерных коммуникаций, площадь помещения, а также стройматериалы и другие факторы.

Больше всего на температуру влияет площадь: чем она меньше, тем быстрее растет температура. И наоборот: чем просторнее серверная комната, тем лучше и быстрее рассеивается тепло.

Материалы разной теплопроводности тоже влияют на процессы теплообмена. Если заменить стены и перегородки из гипсокартона на бетонные стены, а подвесные потолки на железобетонные перекрытия, сохранив толщину, эффективность охлаждения возрастет.

Если стены серверного помещения контактируют с улицей, а не с другим помещением, температура внутри будет зависеть от окружающей среды. Хуже всего в солнечные дни, когда с южной стороны стены дополнительно нагреваются. Летним днем при +38 °C серверы, работающие в небольшой комнате 3×3×3 м, будут перегреваться, так как температура в помещении повысится на 4–7 °C. Цифры приблизительные, потому что все зависит от толщины стен и стройматериалов.

Решения для охлаждения серверных помещений

Не стоит надеяться, что серверное оборудование не остановится из-за перегрева. Решения, которые используются в дата-центре, разнообразны, и только вы можете выбрать нужное вам по сложности и стоимости реализации.

Естественная теплопроводность

Нагретые предметы передают тепло окружающей среде или другим объектам с более низкой температурой. Представьте обычную квартиру, в которой тепло рассеивается по комнатам от нагретых радиаторов. То же происходит в серверном помещении, только здесь уходящее через стены тепло – не зло, как в квартире, а наоборот.

При естественной теплопроводности нагретый воздух из серверной уходит в окружающую среду через стены при условии, что в помещении на несколько градусов теплее. Чем больше разница температур, тем лучше. Это самое неэффективное решение для охлаждения серверных помещений. Его редко используют из-за факторов, влияющих на естественную теплопроводность: климатических особенностей региона, расположения помещения относительно уровня почвы, материалов стен, полов и потолков, площади. Эксперты рекомендуют использовать естественную теплопроводность там, где суммарная мощность потребителей электроэнергии не превышает 1 кВт.

Пассивная вентиляция

Если организовать сообщение между условно более теплыми и холодными смежными помещениями, можно частично решить проблему охлаждения серверов. Делается это через пассивную вентиляцию, когда холодный воздух через воздухозаборники поступает в нагретое помещение. И здесь снова сталкиваемся с ограничением, когда охлаждение работает только для потребителей электроэнергии, суммарная мощность которых не превышает 700 Вт.

Принудительная вентиляция

Чтобы сделать воздухообмен более эффективным, скорость движения воздушных потоков увеличивают с помощью вентиляторов. В таких условиях можно рассчитывать на охлаждение группы потребителей мощностью от 700 Вт до 2 кВт.

В пассивной и в принудительной вентиляции важна не только разность температур в смежных помещениях, но и расположение вентиляционных отверстий по отношению к охлаждаемому оборудованию. И по-прежнему не сбрасываем со счетов материалы стен и перекрытий.

Выделенная система охлаждения

По аналогии с квартирой это будет кондиционер, который охлаждает жилплощадь. Только в дата-центре не получится обойтись одним кондиционером (тем более бытовым) – нужна выделенная система охлаждения с прецизионными кондиционерами. С помощью этих автономных шкафов можно точно регулировать и поддерживать в заданном диапазоне температуру и влажность. Плюс они очищают воздух от пыли, которая вызывает сбои в работе электроники.

Охлаждение кондиционером с вытеснением

Для серверных помещений, где нет фальшпола, используют прецизионные кондиционеры с вытеснением, которые устанавливают на специальную подставку. Это позволяет равномерно распределить воздушные потоки по всему объему комнаты и избежать появления тепловых зон. Подставка кондиционера сконструирована таким образом, чтобы направлять холодный воздух к стойкам. Для этого используют специальную систему экранов и конструкций. Такая конфигурация применяется в небольших серверных, рассчитанных максимум на пять-шесть стоек.

Охлаждение кондиционерами через фальшпол

В серверных с 7 и более стойками устраивают фальшпол, благодаря которому распределяется движение воздуха и соблюдается правило горячего и холодного коридора, в котором не смешиваются потоки с разной температурой, и в серверной не появляются горячие и холодные точки.

Чтобы организовать правильную работу охлаждения, нужно рассчитать высоту фальшпола. Под ним должно поддерживаться постоянное воздушное давление, которое автоматически регулируется в зависимости от колебаний тепловой нагрузки. При наличии фальшпола мощность дата-центра может достигать 200 кВт, а если использовать модульные решения, можно повысить ее до 300 кВт.

Система с вытеснением или фальшполом – не единственная рабочая схема охлаждения ЦОД. Охлаждают и серверные стойки, устанавливая в них специальные кондиционеры, используют системы кондиционирования с модулем прямого или свободного охлаждения. Но у многих прецизионных кондиционеров есть недостатки – они плохо справляются с колебаниями нагрузки и не могут обслужить мощности высокой плотности.

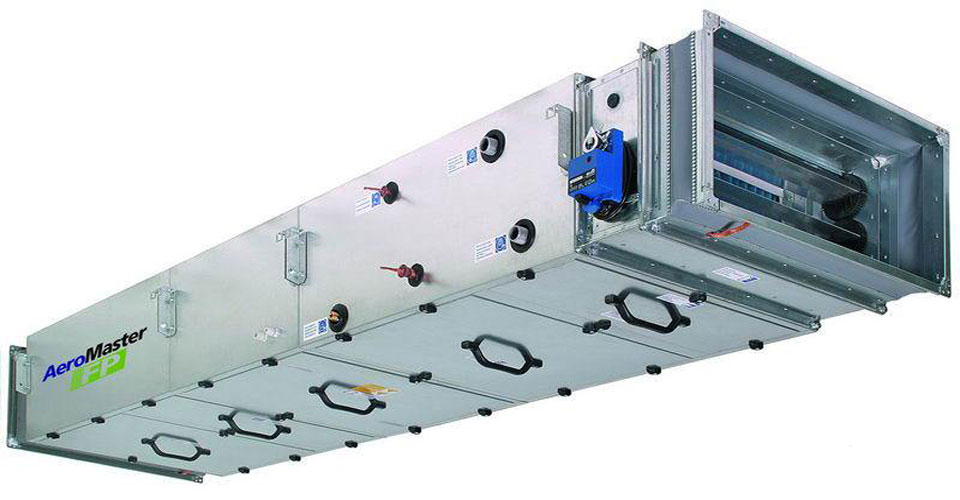

Прецизионные кондиционеры Delta Electronics – решение для современного ЦОД

Повышение плотности мощности и необходимость обслуживать сложные рабочие нагрузки послужило стимулом к разработке прецизионных кондиционеров нового поколения. В компании Delta Electronics они представлены в линейке RowCool. В нее входят воздухоохладители для установки рядом с источником тепла и подачей воздуха вверх/вниз, а также воздухораспределительные блоки.

У Delta Electronics есть внутрирядные кондиционеры RowCool с водяным охлаждением, рассчитанные на потребителей различной суммарной мощности: 29 кВт, 43 кВт, 70 кВт и 90 кВт. Они оснащены одноразовыми фильтрами и вентиляторами с горячей заменой.

Альтернатива для потребителей до 35 кВт – внутрирядные кондиционеры RowCool с наружным конденсаторным блоком и спиральным кондиционером. Отдельно можно приобрести воздухораспределительные блоки InfraSuite ADUВ для монтажа к фальшполу.

Современные ЦОД, обслуживающие ответственные рабочие нагрузки, лучше оснастить решениями серии RoomCool F. Они просты в управлении, техобслуживании и ремонте, для удобного взаимодействия с ними производитель предусмотрел семидюймовый сенсорный экран.

Охлаждение серверной

Вернуться к полной версии

Cравнение товаров:

очиститьСравнить

Чтобы получить коммерческое предложение, позвоните нам по телефону +7 (495) 745-01-41 или отправьте быструю заявку

Чтобы получить коммерческое предложение, позвоните нам по телефону +7 (495) 745-01-41 или отправьте быструю заявку

Реализация охлаждения вспомогательных серверных помещений зачастую откладывается на потом в силу самой роли данных помещений. Между тем охлаждение серверных необходимо, а выбранный способ должен гарантировать поддержание в помещении расчетных параметров воздуха, предоставлять корректные рекомендации по проектированию и установке оборудования, а также обеспечивать минимизацию и оптимизацию среднегодового энергопотребления.

Современные компьютеры обладают большой мощностью. Их процессоры надежно управляют ответственными бизнес-процессами в режиме 24/7, 365 дней в году. Но там, где используется вычислительная мощность, есть также высокая температура. Поскольку компьютеры надежно работают только при температуре около 18-27 ° C, их необходимо охлаждать. Чем эффективнее это охлаждение, тем меньше электроэнергии потребляет центр обработки данных.

ПРИЕМЛЕМАЯ РАБОЧАЯ ТЕМПЕРАТУРА В СЕРВЕРНЫХ

Чтобы правильно подобрать решение для охлаждения серверной, сначала необходимо определить температуру, при которой будет функционировать оборудование в этом помещении. Поставщики обычно указывают максимальную температуру окружающей среды, при которой оно способно работать: для активного ИТ-оборудования средний показатель составляет 40°C (речь идет о температуре, при которой поставщик может обеспечить должную производительность и устойчивость работы своих устройств в течение гарантийного периода).

При этом необходимо помнить, что функционирование в таких условиях не обеспечивает такого же уровня готовности и долговечности, как при более низких температурах. Именно поэтому некоторые поставщики, помимо максимальной, указывают также рекомендованную рабочую температуру. Обычно она составляет от 21 до 24°C.

Рекомендованную и разрешенную для ИТ-оборудования рабочую температуру публикует также технический комитет TC 9.9 Американского общества инженеров по отоплению, охлаждению и кондиционированию воздуха (American Society of Heating, Refrigeration, and Air Conditioning Engineers, ASHRAE). Цель заключается в том, чтобы предоставить ориентир для обеспечения необходимой устойчивости и производительности аппаратных средств. Соответствующие показатели представлены ниже:

|

Особое внимание следует уделить серверным с установленными в них источниками бесперебойного питания (ИБП). Повышение температуры гораздо сильнее влияет на долговечность батарей, чем на другие типы ИТ-оборудования. При 40°C батарея типового ИБП проработает всего 1,5 года, тогда как в нормальных рабочих условиях — 3–5 лет. Поэтому обязательным требованием должна стать температура ниже 25°C. Альтернативным вариантом может быть размещение централизованных ИБП в хорошо охлаждаемом месте за пределами серверной.Температуру следует поддерживать не выше 25°C. Если же это невозможно, в серверных с менее критичным оборудованием верхний предел составляет 32°C. В случае превышения этого показателя есть риск выхода оборудования из строя. 32°C — это тот максимум, который Международная организация по стандартизации (International Organization for Standardization, ISO) считает допустимым при небольшой нагрузке.

Как характеристики помещения определяют температуру

Говоря о температуре в дата-центре, мы имеем в виду не только конкретное оборудование (оно может быть разной мощности и плотности размещения), но и конкретное помещение с его особенностями.

Если серверная обслуживает небольшую компанию и находится в цокольном или подвальном помещении, с охлаждением справится бытовая сплит-система.

Для охлаждения полноценного дата-центра учитывают близость почвы, особенности прокладки инженерных коммуникаций, площадь помещения, а также стройматериалы и другие факторы.

Больше всего на температуру влияет площадь: чем она меньше, тем быстрее растет температура. И наоборот: чем просторнее серверная комната, тем лучше и быстрее рассеивается тепло.

Материалы разной теплопроводности тоже влияют на процессы теплообмена. Если заменить стены и перегородки из гипсокартона на бетонные стены, а подвесные потолки на железобетонные перекрытия, сохранив толщину, эффективность охлаждения возрастет.

Если стены серверного помещения контактируют с улицей, а не с другим помещением, температура внутри будет зависеть от окружающей среды. Хуже всего в солнечные дни, когда с южной стороны стены дополнительно нагреваются. Летним днем при +38 °C серверы, работающие в небольшой комнате 3×3×3 м, будут перегреваться, так как температура в помещении повысится на 4–7 °C. Цифры приблизительные, потому что все зависит от толщины стен и стройматериалов.

Варианты охлаждения серверных

Прецизионный кондиционер

Кондиционер для большой серверной. Самый дорогой, но далеко не всегда оптимальный способ.

Слово «прецизионный» сразу ассоциируется с точностью. Увы, большинство «прецизионных» серверных кондиционеров поставляется с On-Off компрессорами, и ни о каком точном поддержании температуры даже речь не идёт, разбег 2-3 градуса в лучшем случае.

Следующий минус – шум. Обычные прецизионные кондиционеры для серверных — это моноблок с выносным конденсатором. К немалому шуму вентилятора испарителя добавляется шум от компрессора. Хорошо, когда серверная – выделенное необитаемое помещение. Но работать в комнате с работающим «прецизионником» (а бывает и такое) – крайне утомительно.

Цена. Стоимость прецизионного кондиционера – в два-три раза выше полупромышленного инверторного «японца» той же производительности.

Возможно, их единственный плюс – выносной конденсатор, потенциально позволяющий работать прецизионному кондиционеру зимой при более низких температурах, чем обычный кондиционер с зимним комплектом.

Сплит-система

Самое распространённое решение для охлаждения серверных комнат, одновременно универсальное, доступное и недорогое. Самая маленькая «серверная», которую видел автор статьи – шкаф из стеклопластика размером 2м*1м*0,4м, расположенный в комнате айтишников. Естественно, кроме бытового настенного сплита туда ничего поставить было невозможно.

Большинство руководителей организаций всё-таки понимают степень риска потери данных на серверах, и покупают японские кондиционеры для серверной комнаты. Хотя основной тренд российского рынка на удешевление средней стоимости кондиционеров начинает проявляться и здесь.

Предпочтительнее ставить полупромышленный кондиционер для серверной с зимним комплектом, потому что в полупром, даже маленьких номиналов от 9000-12000 BTU, всегда заложен повышенный запас прочности: более надёжный компрессор, увеличенная площадь теплообменников, больше защитных функций.

Приточная вентиляция зимой

Один из вариантов системы free-cooling. Суть системы – собирается наборная приточная установка, и регулирующие заслонки управляют притоком уличного холодного воздуха. Обычно комбинируют со сплит-системой (для работы летом). Главный плюс – бесплатный уличный холод заменяет кондиционер зимой, экономия на электричестве и ресурсе сплит-системы. Минус – не везде возможна установка. Такие системы часто используют, например, на базовых станциях сотовой связи.

Расчёт кондиционера для серверной.

Доводилось видеть ситуации, когда мощность кондиционера для серверной выбиралась исходя из площади помещения, как в квартиру. С предсказуемым результатом. Конечно же, расчёт кондиционера для серверной должен строиться на теплопритоках от оборудования. В идеале, нужно знать притоки от каждого сервера/шкафа. Но зачастую этого не указано в документации. Тогда самый простой способ – посчитать мощность блоков питания серверов, или хотя бы мощность источников бесперебойного питания. Получатся цифры с запасом, но это лучше, чем сделать выбор серверного кондиционера с меньшей производительностью.

Следующий выбор – место расположения внутреннего блока. Поскольку тепло от шкафов поднимается вверх, можно сразу утилизировать его внутренним блоком, подпотолочного или кассетного типа. Но есть опасность, что при недобросовестном монтаже или обслуживании, из внутреннего блока вниз может потечь дренаж. Поэтому внутренний блок серверного кондиционера не должен располагаться непосредственно над сервером или любым электрическим устройством. Лучше всего, когда блок расположен немного в стороне, и поток холодного воздуха дует прямо на оборудование.

Так почему же необходимо и важно поддерживать температурный режим в серверной?

В серверной комнате, как правило, располагается крайне важное и дорогостоящее оборудование. Выход из строя или временные простои в работе оборудования могут привести к материальным и финансовым потерям. Заглянем вовнутрь современного сервера и попробуем выяснить, какие компоненты наиболее критичны к изменению температуры.

Жёсткий диск

Является, пожалуй, самым важным компонентом системы. Соответственно выход из строя жёсткого диска в случае отсутствия резервного может стать критичным для организации. Компоненты жёсткого диска являются чувствительными к изменению температуры: к резким повышениям, понижениям и к перегреву. Повышение температуры, как правило, приводит к расширению материала, из которого изготовлены головки, системы позиционирования головки, магнитные диски. Перегрев может привести к отказу жёсткого диска, что в последствии приводит к нежелательной потере важной и дорогостоящей информации.

Оперативная память

Современная серверная оперативная память снабжена системой пассивного охлаждения и не нуждается в дополнительном охлаждении, тем не менее, стоит помнить, что пассивная система охлаждения эффективна только в определенном диапазоне температур. Если температура в серверной комнате будет повышаться, то никакие радиаторы на линейке памяти не спасут от перегрева оперативную память.

Процессор

Современные процессоры обладают системами защиты от перегрева. Их датчики будут сигнализировать операционной системе о перегреве и предотвращать работу процессора на высоких температурах.

Наборы микросхем на платах

Так называемые северные и южные мосты компьютера также являются мощными выделителями тепла. Обычно указанные контроллеры снабжены радиаторами пассивного охлаждения, но и они чувствительны к изменению температуры воздуха в серверной.

Суммируя все вышесказанное про компоненты сервера, можно с уверенностью сказать, что при определенных диапазонах температур встроенная система охлаждения сервера достаточно эффективна. В ситуации, когда температура выше рабочего диапазона, система охлаждения может не справиться с задачей отвода тепла. Также необходимо избегать резких температурных скачков, что может привести к потере свойств элементов материнской платы сервера.

В серверной комнате может быть сконцентрировано некоторое количество дорогостоящего оборудования, которое критично к повышению температуры, к резким изменениям температурного режима, в связи с чем необходимо правильно подходить к выбору системы охлаждения серверной. Необходимо позаботиться о резервном кондиционере и о системе контроля управления кондиционерами, в случае если возникнет неисправность основного кондиционера. Также необходимо помнить, что большинство современных устройств производит достаточное количество тепла и может за короткий промежуток времени значительно повысить температуру в закрытом помещении. Необходимым также является и правильный выбор сплит-системы, отвечающей требованиям серверной комнаты.

Заключение

Хотелось бы напомнить, что современное вычислительное оборудование разрабатывается с учетом работы в определенных климатических условиях. Поэтому эксплуатация оборудования в условиях, отличных от рекомендованных заводом-изготовителем, может привести к выходу из строя оборудования и, как следствие, отсутствию гарантийного ремонта. Учитывая все изложенное выше, рекомендуем использовать надежные системы контроля климата серверной и надежные системы поддержания климата в серверной.

Группа компаний «ЕвроХолод» готова реализовать комплексные решения по устройству внутренних инженерных систем и сетей зданий. Мы предоставляем гарантию на купленную у нас технику и все монтажные работы!

Группа компаний «ЕвроХолод» готова реализовать комплексные решения по устройству внутренних инженерных систем и сетей зданий. Мы предоставляем гарантию на купленную у нас технику и все монтажные работы!

Наши менеджеры бесплатно проконсультируют Вас по любым вопросам:

Ждем Вашего звонка по телефону: +7(495) 745-01-41

Наш email: [email protected]

О компании , Отзывы , Наши объекты , Контакты

Распечатать

Получить коммерческое предложение

Получите коммерческое предложение по вашему объекту, отправив сейчас быструю заявку.

Опишите кратко суть задачи:

Воздушное охлаждение серверной своими руками / Habr

Охлаждение серверной — актуальная тема.В моем ведении есть помещение 3.5*4м, в котором расположены 5 серверов в корпусах типа Tower. Летом помещение охлаждалось мобильным кондиционером мощностью 1кВт. Выброс тепла осуществляется через гофру на улицу силами самого кондиционера.

Летом кондиционер хорошо справляется с задачей и способен поддерживать температуру в помещении до +19С градусов. Такое решение достаточно дешевое. Цена кондиционера около 13000р. Пообщавшись со специалистами по кондиционерам, выяснил, что такие решения применяют довольно часто, кондиционера хватает на 2-3 года непрерывной работы, после чего выходит из строя компрессор, который гоняет фреон, а его замена обходится примерно в 70% стоимости кондиционера.

Пришла зима. Гофра, отводящая горячий воздух, ощутимо нагревает воздух вокруг себя. Кондиционер перестал отключаться. Температуру держит +22…+23С. Стало его жалко. Город в котором я живу, находится в Сибири, 6-7 месяцев уличная температура ниже +19С. Довольно часто попадаются статьи об охлаждении датацентров «уличным» воздухом. У меня не датацентр, но все же хочется чтобы оборудование жило долго и работало безотказно.

Решено было сделать систему, которая бы контролировала температуру в помещении, и в случае необходимости производила забор холодного воздуха с улицы, и подавала его в серверную. Для забора воздуха будем использовать ту же гофру, по которой летом производился отвод горячего воздуха.

Закупать какие-либо специализированные установки желания не было, вдруг не получится.

Регулятор температуры собрал на ATMega8 + DS1820. При достижении +20С микроконтроллер через оптопару включает реле, которое в свою очередь включает вентилятор для забора воздуха. Как только температура опускается до +19С, забор воздуха прекращается. Точность моего датчика 0.5С. У завхоза взял б.у. вентилятор, скотч и пошел собирать установку. Что из этого получилось, можно увидеть на фотографиях.

Мощность двигателя вентилятора 100Вт, в 10 раз меньше, чем потребляет кондиционер при постоянной работе. Экономия электроэнергии достаточно ощутимая, тем более, что 1кВт стоит дороже, чем для физ. лиц.

Тонкости:

1. Гофра должна быть выведена до самого фасада здания. В моем случае строители не до конца просунули гофру через кирпичную стену и при заборе воздуха всасывалась пыль и крошки от кирпича, пришлось переделать.

2. Датчик лучше расположить на одном уровне с серверами.

3. Руководителю такую штуку вообще лучше не показывать, мой не оценил, сказал что ужасно выглядит. Согласен, что выглядит забавно, но работает, функции свои выполняет и даже электроэнергию экономит.

4. Обязательно отверстие для стравливания избыточного давления. В моем случае оказалось достаточно отверстия в коридор за подвесным потолком.

Что планирую сделать:

1. Установить мелкую сетку на вход гофры со стороны улицы, сейчас достаточно крупная сетка стоит.

2. Установить воздушный фильтр перед вентилятором. Фильтр еще не выбрал.

Микроконтроллер через USART можно подключить к COM порту компьютера и следить за состоянием температуры в серверной. Я в процессе отладки подключал к ноутбуку и в терминале отслеживал показания датчика.

Охлаждение серверной. Разделяй и властвуй / Habr

Всем доброго дня.Так уж случилось что статьи начинают формироваться в цикл. Первая часть цикла находится здесь habrahabr.ru/post/235593

В этой части я попытаюсь упрощенно объяснить зачем нужно управлять воздушными потоками в серверной, как это реализуется, плюсы и минусы различных подходов, а так же экономическое обоснование крупными мазками.

Основные цели у нас:

1. Подать холодный воздух на воздухозаборники оборудования.

2. Забрать горячий воздух с выброса и подача его на воздухозаборник кондиционера.

3. Обеспечение необходимого объема и давления воздуха.

4. Разделение потоков горячего и холодного воздуха.

Для чего это нужно?

Как уже было упомянуто в предыдущей статье, основная проблема с холодом в серверной – это перемешивание воздуха. Перемешивание создает 2 проблемы:

1. Температура воздуха на воздухозаборнике сервера выше, чем требуется.

2. Температура воздуха на воздухозаборнике кондиционера ниже, чем планировалось конструкторами. Это снижает КПД кондиционера, создает проблемы с регулированием, в некоторых системах приводит к ошибкам, которые могут просто отключить кондиционер.

Как решаются эти проблемы?

Разделением потоков. Есть 3 основных способа разделения потоков:

1. Изоляция на уровне стойки (Rack Air Containment System — RACS).

2. Изоляция холодного коридора (Cold Air Containment System — CACS).

3. Изоляция горячего коридора (Hot Air Containment System — HACS).

Изоляция на уровне стойки выглядит следующим образом

На картинке изображен рядный кондиционер и стойка, доукомплектованные элементами RACS.

RACS используют в 3-х случаях:

1. Когда нужно повысить холодопроизводительность рядного кондиционера, который охлаждает непосредственно эту стойку. Рядные прецизионные кондиционеры спроектированы для работы с высокой температурой обратного воздуха. Чем выше температура, тем больше холодопроизводительность кондиционера. Опять таки, чем меньше холодный воздух расходится по помещению, тем больше его попадает на воздухозабор стойки.

2. Когда нужно охладить стойку в большом помещении, но само помещение охлаждать не эффективно.

3. Когда в помещении находятся, например, стандартные стойки с тепловыделением 5-8 кВт и пара стоек с тепловыделением 20-70 кВт. В этом случае вы строите одну систему для всех стоек с применение дорогих специализированных решений. Либо строите простую систему на базе периметральных кондиционеров для стоек с низким потреблением, и строите отдельный контейнер для высоконагруженных стоек.

Изоляция холодного коридора выглядит так:

Для CACS требуется расположить шкафы в один ряд напротив стены либо в 2 ряда друг напротив друга. Зона подачи холодного воздуха перекрывается крышей и дверями/шторками, создавая изолированный объем.

CACS – это довольно традиционный вариант. Его применяют уже давно, в силу сложившихся традиций цодостроения, когда стойки размещаются лицом друг к другу. Поэтому это наиболее подходящий вариант для модернизируемых ЦОД.

Изоляция горячего коридора выглядит так:

Точно так же как и для CACS, HACS требует рядного размещения шкафов, с той лишь разницей, что шкафы должны располагаться «спиной» друг к другу. Изолируется при этом зона горячего воздуха.

И в том и другом случае возможно применение как рядных, так и периметральных кондиционеров. В случае с CACS, для подачи воздуха может использоваться фальшпол, забор горячего воздуха производится из объема помещения. В случае с HACS подача производится в объем помещения. В периметральном охлаждении для забора воздуха используется пленум фальшпотолка или воздуховоды. При этом крыша коридора меняется на воздуховод (есть ещё термин chimney – дословно «печная труба»), как на картинке выше.

В качестве варианта использования HACS, можно применять так называемые «вытяжные двери». Это блок с вентиляторами, который навешивается вместо задней двери шкафа и обеспечивает забор воздуха и подачу его в пленум фальшпотолка. Специфическая вещь, может использоватся когда необходимо изолировать несколько стоек в помещении, или когда производится модернизация старых ЦОДов, где шкафы размещались хаотично, а передвинуть их для формирования коридора нет возможности.

Очень важный момент при использовании систем изоляции. Не нужно думать, что если вы закрыли крышу и торцы коридора, ваша работа выполнена на «отлично». Есть ещё куча дыр, которые нужно перекрыть:

1. Пустые юниты в шкафах. Используем специальные заглушки, картон, поликарбонат, доски.

2. Щели между шкафами. Покупаем у производителя шкафов специальные заглушки или берем полиуретановую самоклеющуюся ленту.

3. Щели между плитками фальшпола, щели в местах примыкания фальшпола к стенам и конструктивным элементам. Используем уплотнители на стрингеры пола (у вас ведь пол в ЦОДе собран со стрингерами). В местах примыкания к стенам – опять таки ленту из п.2.

4. Кабельные вводы, через которые воздух может перетекать из одной зоны в другую. Здесь нужно использовать щеточные вводы.

Особенности использования той или иной системы.

RACS. Тут все классно за исключением проблем с пожаротушением. Необходимо либо создавать единый объем с помещением путем реализации автоматического открытия дверей, либо заводить пожаротушение в RACS.

CACS и HACS. Основное отличие в том, какой воздух у нас в помещении – холодный или горячий. При использовании CACS мы не сможем разместить в помещении нестоечное оборудование, поскольку всё помещение у нас будет зоной горячего воздуха. Температура там может достигать 35 градусов и выше. С HACS таких проблем нет. Опять же согласно санитарным нормам, работать при высокой температуре можно ограниченное количество времени. Это исключает проведение длительных работ в помещении при использовании CACS. Ну и третье – запас холодного воздуха при аварии кондиционеров разный, у HACS он больше. Очень важный момент при использовании пленумов для подачи воздуха – турбулентность. Если вы используете фальшпол, необходимо предусмотреть достаточное его сечение. Оперировать мы можем только высотой, поскольку площадь у нас определяется помещением. Уменьшение высоты приводит к увеличению скорости потоков воздуха (объем воздуха у нас ведь постоянный), высокие скорости в условиях большого количества преград (в виде стоек фальшпола, лотков и т.п.) приводит к образованиям завихрений (турбулентность), турбулентность приводит к снижению давления, следовательно уменьшается объем воздуха, которые выходит непосредственно из перфорированных плиток пола. Нам необходимо всегда стремиться к ламинарному потоку. Для расчета высоты можно применять CFD софт (правильно и с наибольшей достоверностью), либо производить примерный расчет. Мощная статья на эту тему www.ccc.ru/magazine/depot/07_12/read.html?Wcd7c2146c471e.htm.

Экономика.

Одни хорошие ребята провели математическое моделирование. Для расчета был взят один и тот же ЦОД. На рядном охлаждении посчитали CAPEX и OPEX с HACS и без. На периметральном охлаждении считали CAPEX и OPEX, сравнивая HACS и CACS. Что же показало исследование?

1. В рядном охлаждении решение с изолированными коридорами в среднем на 5-7% дешевле в CAPEX. За счет увеличения capture index (возможность кондиционера «захватить» горячий воздух) снизилось количество применяемых кондиционеров. Операционные затраты также снижаются за счет снижения количества кондиционеров (снижение электропотребления) и за счет повышения КПД, поскольку мы смогли повысить температуру в горячем коридоре.

2. В периметральном охлаждении все запутаннее. Самый низкий CAPEX у решения без изоляции. Но данные решения могут применяться только до мощностей 5-7 кВт на стойку. Дальше только изоляция. До мощностей 12-15 кВт на стойку CACS дешевле HACS на 2-6%, поскольку для HACS требуется система отвода горячего воздуха (воздуховоды, пленум фальшпотолка). Однако после этого порога, для CACS требуется применение доводчиков воздуха из-под фальшпола, что существенно удорожает решение (на 7-10%). Операционные затраты для изолированных решений ниже на 12% чем для неизолированных. При этом до порога 12-15 кВт на стойку затраты CACS и HACS одинаковы и начинают расходиться после этого порога. CACS становится в среднем на 4% дороже, потому что в баланс добавляется потребление доводчиков воздуха.

Как же выбрать то, что вам подойдет?

Если потолки низкие (следовательно нет возможности установить фальшпол) стройте рядное решение с HACS при любых плотностях.

Если у вас низкая плотность (до 6 кВт на стойку) и высокие потолки, стройте периметральное решение без изоляции с раздачей воздуха под фальшпол.

Если у вас высокие плотности (15 и выше кВт) стройте HACS, рядное или периметральное – зависит от геометрии помещения.

Если плотность средняя (6-12 кВт) стройте CACS.

Пограничные случаи требуют расчетов и моделирования, все зависит от резервирования, количества стоек и геометрии помещения. Чаша весов может склониться в любую сторону.

На этом все, если будут вопросы – отвечу в комментариях.